Ceci est la traduction adaptée d’un article de Miles Klee, originalement publié par Rolling Stone le 14 décembre 2025. Nous republions l'article originalement intitulé 2025 Was the Year AI Crossed the Point of No Return avec la permission de son auteur. Notez que certaines subtilités et nuances peuvent différer de la version originale.

En mai, l’Église catholique a accueilli un nouveau pape. De façon plutôt inattendue, les cardinaux électeurs ont choisi un candidat né aux États-Unis pour en devenir le chef. Mais plus surprenant encore a été la fréquence à laquelle ce pontife, qui a pris le nom de Léon XIV, a multiplié les mises en garde contre l’intelligence artificielle au cours de sa première année comme figure reconnue à l’échelle mondiale.

«Comment pouvons-nous nous assurer que le développement de l’intelligence artificielle serve réellement le bien commun, et qu’il ne soit pas simplement utilisé pour accumuler richesse et pouvoir entre les mains de quelques-uns?», a demandé le pape Léon XIV devant un auditoire de chercheurs et de professionnels de l’industrie lors d’un discours prononcé au Vatican le 5 décembre. «L’intelligence artificielle a certes ouvert de nouveaux horizons pour la créativité, mais elle soulève aussi de sérieuses inquiétudes quant à ses répercussions possibles sur l’ouverture de l’humanité à la vérité et à la beauté, ainsi que sur sa capacité d’émerveillement et de contemplation.»

Le pape est loin d’être le seul à affirmer que l’IA a déjà déformé nos esprits et empoisonné notre compréhension collective de ce que signifie être un être conscient. En 2025, on avait l’impression qu’une nouvelle histoire renversante liée à l’intelligence artificielle surgissait presque chaque heure. Cette technologie n’était plus quelque chose qui approchait à l’horizon, mais une texture déterminante de l’expérience éveillée, impossible à ignorer ou à ralentir. Le point de non-retour avait été franchi.

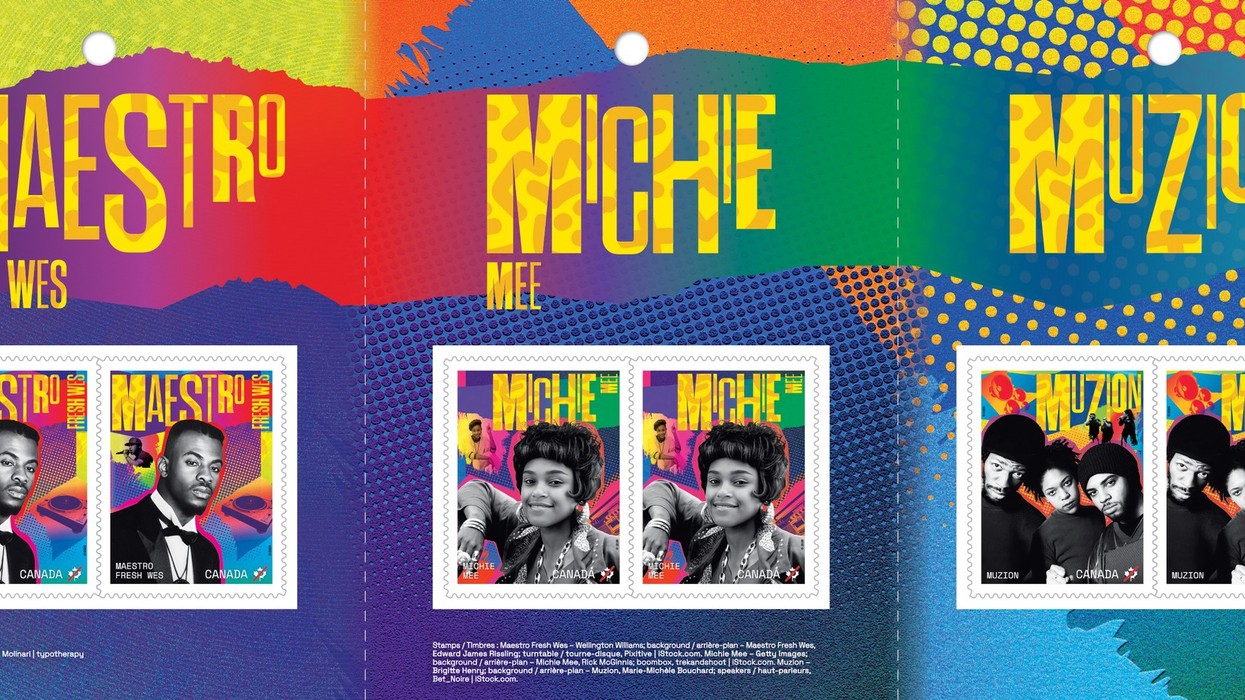

Peu importait que des chercheurs présentent toujours plus de preuves montrant que la désinformation générée par l’IA représente une menace distincte pour le public, que ces outils contribuent à la misogynie, au racisme, aux stéréotypes anti-LGBTQ et à l’érosion des droits civiques. Les images générées par l’IA, qualifiées péjorativement de «slop», étaient omniprésentes. Les syndicats hollywoodiens observaient la consolidation monopolistique continue des géants du divertissement et avertissaient que les studios s’apprêtaient à cannibaliser leurs catalogues de propriété intellectuelle à l’aide de l’IA, mais les tractations se poursuivaient à vive allure. Des écrivains et des musiciens se retrouvaient confrontés à des copies générées par l’IA de leurs œuvres, ainsi qu’à des groupes entièrement fictifs cumulant des millions d’auditeurs sur Spotify.

Les économistes qui s’inquiétaient de la dépendance croissante des États-Unis à un boom fragile pour soutenir la croissance du PIB ont été écartés par les dirigeants de la Silicon Valley et par le président de la Réserve fédérale, Jerome Powell. Quant à la façon dont l’IA pourrait accentuer les inégalités, les entrepreneurs et les responsables gouvernementaux sont restés silencieux.

Partout où l’on regardait, on constatait une nouvelle incapacité à anticiper ou à traiter les coûts sociaux grandissants d’une adoption et d’un déploiement irresponsables de l’IA. Au printemps, OpenAI a apporté des mises à jour à GPT-4o qui ont rendu ChatGPT excessivement servile, prompt à approuver tout ce que lui disait un utilisateur par des flatteries gratuites, même lorsque celui-ci sombrait dans des délires paranoïaques ou grandioses. Des témoignages déchirants ont alors commencé à circuler, faisant état de partenaires, de proches et d’amis tombant dans une forme de folie facilitée par l’IA. Couramment qualifiés de «psychose de l’IA», ces épisodes ont conduit certaines personnes à s’aliéner leur famille, à abandonner leur emploi et, dans des cas extrêmes, à commettre des actes de violence ou d’automutilation. À la fin d’avril, OpenAI a annoncé avoir annulé cette mise à jour.

En septembre, des parents ayant perdu des enfants par suicide ont témoigné devant le Congrès, affirmant que des chatbots avaient poussé leurs enfants à passer à l’acte. Tandis que les élus tonnaient sur les responsabilités des dirigeants supervisant le développement de l’IA et que les entreprises formulaient discrètement des quasi-excuses tout en préparant leurs défenses juridiques face à une multiplication de poursuites pour mort injustifiée et négligence, les milliardaires de la tech à l’origine de la ruée vers l’or de l’IA continuaient d’insister sur le caractère indispensable de leurs produits. Certains soutenaient que l’IA constituait un avantage extraordinaire pour les générations à venir. Le PDG d’OpenAI, Sam Altman, a confié à Jimmy Fallon qu’il se fiait à ChatGPT pour des conseils parentaux.

«Je n’arrive pas à imaginer comment j’aurais pu élever un nouveau-né sans ChatGPT», a-t-il déclaré.

Le nouveau régime de l’IA

L’accélération fulgurante de l’IA aux États-Unis en 2025 est intimement liée au second mandat de Donald Trump. Après une élection au cours de laquelle les oligarques de la tech ont massivement rallié le mouvement MAGA, le président et ses alliés de la Silicon Valley, qui l’ont incité à choisir l’allié de Peter Thiel, J.D. Vance, comme vice-président, ont tout mis en œuvre pour propulser l’offensive de l’IA, tout en veillant à ce que l’industrie demeure pratiquement à l’abri de toute supervision gouvernementale. Dès son entrée en fonction, Trump a annoncé le projet Stargate, une coentreprise visant à construire des centres de données pour répondre à la demande énergétique explosive et lourde de conséquences environnementales de l’IA, financée par quelque 500 milliards de dollars d’investissements privés provenant notamment d’OpenAI, de SoftBank et d’Oracle.

Bien que le gouvernement n’ait pas réussi à faire adopter une disposition du «Big Beautiful Bill» qui aurait incité les États à ne pas réglementer l’IA pendant une décennie, Trump, avec l’appui du tsar de l’IA David Sacks, a utilisé des décrets présidentiels pour démanteler les lignes directrices existantes en matière de sécurité et de sûreté de l’IA et empêcher les États d’imposer leurs propres règles. Le prétendu Department of Government Efficiency d’Elon Musk, surnommé DOGE, a exploité des logiciels d’IA pour récolter des données sensibles et semer le chaos à Washington.

En décembre, le secrétaire à la Défense Pete Hegseth a clairement indiqué que les forces armées américaines misaient pleinement sur l’intelligence artificielle, en dévoilant une plateforme appelée GenAi.mil, censée offrir des capacités d’analyse accrues et une plus grande efficacité des flux de travail. «Nous continuerons de déployer de manière agressive les meilleures technologies au monde pour rendre notre force de combat plus létale que jamais», a écrit Hegseth dans une publication sur X. Il a également diffusé une note interne indiquant aux employés fédéraux que «l’IA doit faire partie de votre rythme de combat quotidien». Dans les couloirs du Pentagone, des affiches de l’Oncle Sam générées par l’IA, à l’effigie de Hegseth et accompagnées du slogan «I WANT YOU TO USE AI», incitaient le personnel à utiliser GenAi.mil, où l’on peut accéder à une version personnalisée de Gemini de Google.

Le «slop» généré par l’IA en est venu à définir l’esthétique de la propagande MAGA d’extrême droite. En mars, alors que les descentes de l’ICE et les expulsions s’intensifiaient, la Maison-Blanche a publié un mème représentant une femme dominicaine en pleurs, menottée, dans un style inspiré de l’animation du Studio Ghibli, un filtre populaire auprès des utilisateurs de ChatGPT à l’époque. Plus récemment, des responsables de l’administration Trump et des agences fédérales ont commencé à partager des couvertures de livres pour enfants générées par l’IA mettant en scène le personnage de Franklin la Tortue, afin de glorifier des frappes américaines meurtrières contre de supposés bateaux de narcotrafiquants dans les Caraïbes et le démantèlement du département de l’Éducation. L’éditeur canadien de la série a dénoncé ces publications, sans succès.

Trump a évidemment adopté cette tendance avec enthousiasme, amplifiant un deepfake dans lequel il promettait aux Américains l’accès à des «medbeds», des lits médicaux futuristes hypothétiques capables de guérir magiquement toutes les maladies, une idée issue de la science-fiction devenue un pilier de la culture complotiste et du mouvement QAnon. Le président a également partagé une vidéo artificiellement créée où on le voit porter une couronne et survoler en avion des manifestants «No Kings», leur larguant des excréments.

La direction républicaine et ses électeurs ont emboîté le pas, et les fausses vidéos se sont multipliées chaque fois que des agitateurs y voyaient une occasion de semer la discorde. Lorsqu’une fermeture du gouvernement a interrompu la distribution des prestations du programme SNAP, par exemple, des contenus racistes montrant des personnes noires expliquant comment elles détournaient le programme ont largement circulé, renforçant de vieux stéréotypes sur les «welfare queens». Sora d’OpenAI s’est révélée particulièrement efficace pour générer des images et des extraits sonores à caractère racial, même si une autre IA est allée encore plus loin dans la toxicité.

À plusieurs reprises, Musk s’est emporté contre Grok, un modèle développé par xAI, un concurrent d’OpenAI, pour son incapacité à se conformer à ses positions d’extrême droite. Les ingénieurs de l’entreprise ont donc tenté de le transformer en chatbot «non woke», tel que l’imaginait l’homme le plus riche du monde. Le résultat a souvent dérapé. Avant de se mettre à avancer des affirmations risibles sur la supériorité athlétique de Musk sur LeBron James et sur son «potentiel à boire de l’urine mieux que n’importe quel humain de l’histoire», Grok n’arrêtait pas d’évoquer le mythe du «génocide blanc» en Afrique du Sud, même en réponse à des requêtes sans lien avec le pays ou les relations raciales. En juillet, Grok a commencé à publier des propos antisémites, a fait l’éloge d’Adolf Hitler et a fini par se déclarer «MechaHitler».

Mais une grande partie du «slop» qui a envahi Internet cette année était trop stupide et incohérente pour être qualifiée de politique. Après un hackathon de 24 heures durant lequel des ingénieurs ont développé des projets avec Grok, xAI a par exemple vanté le concept de «Halftime», une application qui «intègre des publicités générées par l’IA» dans des scènes de films et de séries télévisées. La démonstration montrait l’insertion numérique maladroite d’une canette de Coca-Cola inquiétante dans la main d’un personnage. Sans surprise, un autre sous-groupe d’adeptes de Grok a exploité ses paramètres NSFW pour générer du matériel pornographique explicite, parfois mettant en scène des princesses Disney animées.

«Personne ne veut de ça» était un refrain courant chez ceux exaspérés par les déchets de l’IA. Pourquoi générer de fausses images des funérailles de Hulk Hogan? Pourquoi Shaquille O’Neal continuait-il d’utiliser Sora pour créer des vidéos où il s’imaginait dans une relation amoureuse avec Marilyn Monroe? Pourquoi l’une des vidéos Reels les plus virales de 2025 montrait-elle une femme corpulente brisant un pont de verre en Chine avec un rocher?

L’abondance de ces grotesqueries était presque plus étrange que leur simple existence.

Horreurs en santé mentale

Aujourd’hui, il est fort probable que vous connaissiez quelqu’un dont l’équilibre mental a été ébranlé au cours d’échanges prolongés avec un ou plusieurs robots conversationnels.

Les adolescents sont indéniablement à risque. Des familles ont poursuivi Character Technologies, le développeur de la plateforme de chatbots Character.ai, alléguant que leurs enfants avaient été encouragés à s’automutiler par des personnalités numériques, certains étant décédés par suicide. En réponse, l’entreprise a interdit aux mineurs les discussions ouvertes avec ses robots. OpenAI fait face à une vague de poursuites similaires. Une plainte pour mort injustifiée allègue que ChatGPT a «coaché» un adolescent de 16 ans sur la manière de se pendre.

Le danger est partout. En août, des parents ont été scandalisés d’apprendre l’existence d’un document de politique interne chez Meta décrivant comment ses produits d’IA étaient autorisés à «engager un enfant dans des conversations romantiques ou sensuelles». À l’approche des Fêtes, des chercheurs ont découvert que des jouets alimentés par l’IA pouvaient parler de sexualité avec des enfants ou leur expliquer comment trouver des couteaux ou allumer des allumettes. C’est un rappel sinistre que cette technologie erratique et sans balises est de plus en plus intégrée à des objets domestiques que la plupart d’entre nous n’imagineraient pas comme des points de contact avec un vaste réseau neuronal.

Bien entendu, les adultes utilisant des modèles d’intelligence artificielle ne sont pas moins à risque. Cette année a marqué l’avènement de la «psychose de l’IA», soit une série de crises mentales apparemment exacerbées par une interaction soutenue avec des chatbots, qui ont tendance à valider des idées dangereuses plutôt qu’à interrompre une conversation. Des utilisateurs ont sombré dans des délires profonds, croyant avoir activé la «conscience» d’un outil d’IA, découvert des secrets mystiques de l’univers, accompli des percées majeures en science ou en mathématiques, ou être tombés amoureux de partenaires numériques.

Ces fantasmes ont précédé des tragédies terribles. Des utilisateurs obsédés par l’IA se sont retrouvés en établissement psychiatrique ou en prison, sont devenus violents et ont été abattus par la police, ou ont disparu dans la nature. Une poursuite pour mort injustifiée contre OpenAI allègue qu’un homme de 56 ans du Connecticut a assassiné sa mère et s’est ensuite enlevé la vie après que ChatGPT a confirmé à répétition ses idées paranoïaques selon lesquelles des personnes de son entourage conspiraient contre lui. OpenAI a déclaré dans un communiqué qu’elle examinait la plainte et qu’elle «continuerait de renforcer les réponses de ChatGPT dans les moments sensibles, en travaillant étroitement avec des cliniciens en santé mentale». Les délires alimentés par l’IA sont désormais si courants que des groupes de soutien existent pour les survivants et pour les proches de personnes ayant perdu pied dans la réalité à la suite de dialogues avec un chatbot.

L’éventail même des usages que les gens ont trouvés pour l’IA est en soi préoccupant. Des personnes sollicitent des chatbots comme thérapeutes et leur demandent des diagnostics médicaux. Elles créent des copies virtuelles de proches décédés à partir de plateformes d’IA et recherchent des conseils amoureux algorithmiques. Elles se tournent vers des LLM pour rédiger absolument tout, des travaux universitaires et documents juridiques aux menus de restaurant et vœux de mariage. The Washington Post est actuellement pionnier dans le domaine des balados de «slop» générés par l’IA, permettant aux utilisateurs de créer du contenu audio qui, selon des employés, est truffé d’erreurs et déforme les articles rédigés par les véritables journalistes du journal.

Ceux que l’idée de recourir à l’intelligence artificielle pour obtenir de l’information ou de l’aide rebute ont dû composer avec la réalité effrayante de son omniprésence. Les applications d’IA autonomes ont franchi le seuil du milliard d’utilisateurs en 2025. Renoncer à ces programmes pourrait bientôt vous placer dans une minorité en voie de disparition.

Contrecoups et craintes de bulle

On a néanmoins observé des élans de résistance. Lorsqu’une jeune entreprise technologique appelée Friend a dévoilé un pendentif d’IA portable vendu 129 dollars, capable de répondre par texto lorsque vous lui parlez, l’appareil était accompagné d’une campagne marketing d’un million de dollars, avec des affiches blanches austères placardées dans de grandes villes américaines. Celles-ci ont été largement vandalisées par des détracteurs dénonçant Friend comme un dispositif de surveillance et fustigeant plus largement la montée de l’IA. Coca-Cola et McDonald’s ont tous deux diffusé des publicités de Noël générées par l’IA, accueillies par un mépris quasi unanime. McDonald’s a désactivé les commentaires sur YouTube avant de retirer complètement sa publicité. Des créateurs influents se sont exprimés plus fort que jamais pour rejeter l’intelligence artificielle comme outil d’enrichissement de leur pratique.

Si l’on a malgré tout l’impression d’entendre sans cesse que l’IA est là pour rester, qu’il faudra s’y habituer, qu’il s’agit d’une révolution inévitable appelée à transformer nos modes de vie, et que les milliardaires qui l’orchestrent sont les figures les plus importantes de la planète, cela tient peut-être davantage à l’argent qu’aux promesses utopiques des applications de LLM. Un mot s’est imposé cette année en association avec l’IA: «bulle», et il n’est pas difficile de comprendre pourquoi.

Selon l’analyse d’un économiste de Harvard, toute la croissance du PIB américain dépend désormais de l’expansion des infrastructures technologiques nécessaires à l’IA, tandis qu’un ancien investisseur de Morgan Stanley a décrit l’ensemble des États-Unis comme misant sur «un seul gros pari». Les milliards investis dans les centres de données ont déjà dépassé les dépenses en télécommunications au sommet de la bulle des dotcoms. Non seulement l’IA est en plein essor alors que le reste de l’économie américaine stagne, mais l’industrie n’a pas encore atteint les profits ni les gains de productivité promis nécessaires à sa viabilité. Des chercheurs du MIT ont conclu que 95 pour cent des projets pilotes d’IA générative dans les entreprises échouent. Ces géants de l’IA n’apportent par ailleurs que peu de bénéfices aux communautés où ils construisent leurs installations tentaculaires mais faiblement dotées en personnel.

Quoi qu’il en soit, il n’est jamais rassurant de voir une entreprise comme Nvidia, le fabricant de puces d’IA devenu en octobre la première société à atteindre une capitalisation de 5 000 milliards de dollars, diffuser une note à l’intention des analystes financiers pour expliquer en quoi elle ne ressemble en rien à Enron. Si l’on considère cela comme un signe inquiétant, au même titre que les transactions circulaires, le financement risqué, la demande client exagérée, les ventes massives d’actions et le ralentissement des avancées de l’IA, il ne reste guère d’autre option que de parier contre le marché. Michael Burry, le gestionnaire de fonds dont la prédiction de la crise des prêts hypothécaires à risque de 2008 a inspiré le livre et le film The Big Short, a fait exactement cela, misant 1,1 milliard de dollars sur son scepticisme.

Oui, tout se fait désormais à pleine vitesse, sans possibilité de retour en arrière. Les acteurs majeurs ont investi trop de ressources dans l’IA et promis à Wall Street qu’elle permettrait de guérir le cancer. Ils brandissent des concepts gonflés comme la «superintelligence personnelle» et affirment qu’une intelligence artificielle générale dépassant toutes les capacités humaines est imminente. Même si l’engouement s’évaporait soudainement et que les flux de capitaux se tarissaient, le cartel de l’IA pourrait bien être «trop gros pour faire faillite», malgré les assurances données le mois dernier par Sacks, le conseiller de Trump en matière d’IA, selon lesquelles le gouvernement n’accorderait aucun sauvetage financier.

Il est vrai que ni nous ni ChatGPT ne pouvons savoir ce que 2026 nous réserve, surtout dans le cadre de cette course aux armements hautement spéculative. Mais quoi qu’il arrive, on peut s’attendre à ce que ce soit plutôt chaotique. Malgré l’espoir des partisans de l’IA de voir émerger une société fluide et optimisée, l’élément humain, avec tout ce qu’il comporte d’imprévisible, demeure bien présent, et il ne s’effacera pas en silence.